谷歌:人類語言波形直接建模

發布時間:2016/12/22 10:14:05 訪問次數:10931

在人機交互和機器語音識別領域,google和其他科技公司已經取得了巨大的進步。但是,要想做到使機器語音如同人類說話那樣自然流暢,迄今為止一直都是機器學習領域的一大難題。

- 51電子網公益庫存:

- 74HCT7541PW-Q100J

- 74LVC16373APAG

- 74LVC16374ADGG-Q1J

- 74LVC16374ADL112

- 74LS02

- 74HC165D653

- 74HC175PW112

- 74HC175PW118

- 74HC175PW-Q100J

- 74HC14

- 74HCT174DB112

- 74HCT174DB118

截至目前,大多數的文本閱讀(text-to-speech ,tts)系統都是基于所謂的語音拼接技術,這嚴重依賴于單詞組合的語音片段數據庫。這就會產生因為數據庫不完善,而導致的語音突變或者斷句錯誤等問題,讓人聽起來很不自然。

通過對人類語言的原始波形進行直接建模,deepmind正在改變語音合成的方式。在wavenet平臺上,這一先進的方法可以合成任意類型的語音,甚至包括音樂。下面就是通過語音拼接技術和wavenet語音合成的例子,可以感受一下語音品質。

0:05語音拼接技術合成的聲音 來自deeptech深科技

將人類語音的原始波形進行直接建模成波形是件無比困難的工作,這對于機器學習而言,無疑是個巨大的挑戰。

在建模的過程中,每秒都需要對下一時刻做上千個預測,而大多數預測都是基于前期的結果。deepmind利用神經網絡技術,并用人類語音波形對其進行訓練,在下面的gif動畫中,你可以看到多層計算網絡來估計語音概率分布,進而得出最終輸出音頻。

多層計算網絡來估計語音概率分布

通過對輸出音頻的比較,deepmind團隊發現,wavenet產生的音頻比其他方法得到的合成語音更加逼真。甚至對于wavenet來說,即使沒有輸入文本,神經網絡也能得到相應的輸出音頻。

只不過,這時你聽到的是機器的牙牙學語,聽起來就像是一個人在說你從未聽過的語言。這時,如果你使用古典鋼琴曲而不是人聲來訓練,這種機器的“咕嚕”聲就會變成狂亂但是有趣的音樂片段。

十幾年前,人工智能開始出現在我們生活中。現在,我們把調侃siri當成一種樂趣。試想一下,未來幾年,從冰冷的手機揚聲器中,如果傳來的比你男/女朋友還溫柔的聲音,你還有心思去談戀愛嗎?現在,那個憑借開發alphago火爆全球google deepmind團隊,正在為你量身打造一款你喜歡的另一半。

的確,我們從呱呱墜地到呀呀囈語,早就習慣了人類語言的語氣和發聲模式,任何聲音只要有一絲偏離我們意識中的“正常”語言,都會被我們馬上辨認出來。這就是為什么一直以來開發真正人聲語音文本是件極其困難的工作。

但是現在,google的deepmind ai研究團隊通過改變他們的機器學習模型,解決了這一難題,并且在“wavenet”平臺上展示出了他們驚人的科學成果。

在人機交互和機器語音識別領域,google和其他科技公司已經取得了巨大的進步。但是,要想做到使機器語音如同人類說話那樣自然流暢,迄今為止一直都是機器學習領域的一大難題。

- 51電子網公益庫存:

- 74HCT7541PW-Q100J

- 74LVC16373APAG

- 74LVC16374ADGG-Q1J

- 74LVC16374ADL112

- 74LS02

- 74HC165D653

- 74HC175PW112

- 74HC175PW118

- 74HC175PW-Q100J

- 74HC14

- 74HCT174DB112

- 74HCT174DB118

截至目前,大多數的文本閱讀(text-to-speech ,tts)系統都是基于所謂的語音拼接技術,這嚴重依賴于單詞組合的語音片段數據庫。這就會產生因為數據庫不完善,而導致的語音突變或者斷句錯誤等問題,讓人聽起來很不自然。

通過對人類語言的原始波形進行直接建模,deepmind正在改變語音合成的方式。在wavenet平臺上,這一先進的方法可以合成任意類型的語音,甚至包括音樂。下面就是通過語音拼接技術和wavenet語音合成的例子,可以感受一下語音品質。

0:05語音拼接技術合成的聲音 來自deeptech深科技

將人類語音的原始波形進行直接建模成波形是件無比困難的工作,這對于機器學習而言,無疑是個巨大的挑戰。

在建模的過程中,每秒都需要對下一時刻做上千個預測,而大多數預測都是基于前期的結果。deepmind利用神經網絡技術,并用人類語音波形對其進行訓練,在下面的gif動畫中,你可以看到多層計算網絡來估計語音概率分布,進而得出最終輸出音頻。

多層計算網絡來估計語音概率分布

通過對輸出音頻的比較,deepmind團隊發現,wavenet產生的音頻比其他方法得到的合成語音更加逼真。甚至對于wavenet來說,即使沒有輸入文本,神經網絡也能得到相應的輸出音頻。

只不過,這時你聽到的是機器的牙牙學語,聽起來就像是一個人在說你從未聽過的語言。這時,如果你使用古典鋼琴曲而不是人聲來訓練,這種機器的“咕嚕”聲就會變成狂亂但是有趣的音樂片段。

十幾年前,人工智能開始出現在我們生活中。現在,我們把調侃siri當成一種樂趣。試想一下,未來幾年,從冰冷的手機揚聲器中,如果傳來的比你男/女朋友還溫柔的聲音,你還有心思去談戀愛嗎?現在,那個憑借開發alphago火爆全球google deepmind團隊,正在為你量身打造一款你喜歡的另一半。

的確,我們從呱呱墜地到呀呀囈語,早就習慣了人類語言的語氣和發聲模式,任何聲音只要有一絲偏離我們意識中的“正常”語言,都會被我們馬上辨認出來。這就是為什么一直以來開發真正人聲語音文本是件極其困難的工作。

但是現在,google的deepmind ai研究團隊通過改變他們的機器學習模型,解決了這一難題,并且在“wavenet”平臺上展示出了他們驚人的科學成果。

熱門點擊

熱門點擊

- 石墨烯電池或將取代鋰電池

- 改變人類歷史的大發明

- 科學家:宇宙是三維全息投影

- 微軟:翻譯App

- 燃料電池的氫來源全程零排放

- 中資收購德企,為何奧巴馬說了算

- 中國的廉價手機對三星和蘋果都構成了威脅

- 德勤報告:未來汽車全新商業生態系統

- 微電子定義和推動未來的消費趨勢

- 無人駕駛技術“零故障”背后最大的隱患

推薦電子資訊

推薦電子資訊

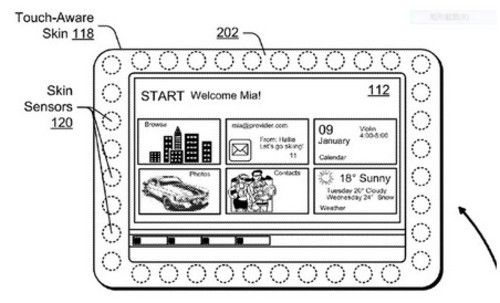

- 微軟新專利:皮膚感應邊框

- 該專利名為“基于抓握的裝置適應(Grip-Based&... [詳細]

公網安備44030402000607

公網安備44030402000607